Карманные мозги, что управляют всем: микроконтроллеры от первых 4-бит до IoT-революции

Исторический обзор появления микроконтроллеров

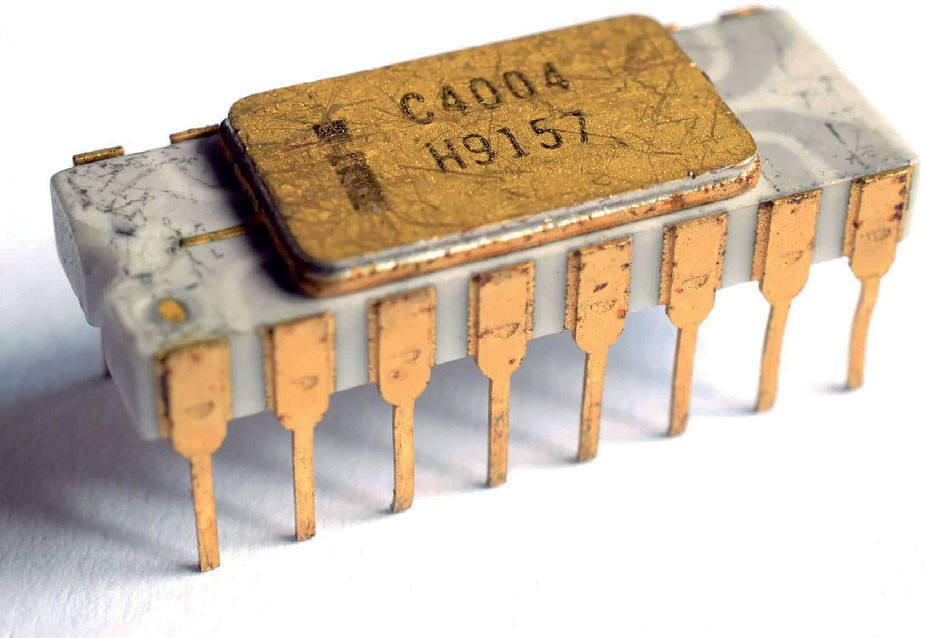

Микроконтроллеры возникли из потребности создать маленький компьютер на одном чипе, способный управлять устройствами дешевле, чем связка отдельного процессора, памяти и периферии. Первый в мире микропроцессор Intel 4004 (1971) требовал множество внешних микросхем памяти и логики, что делало его применение в массовых приборах слишком дорогим.

Прорыв произошел в 1974 году, когда инженеры Gary Boone и Michael Cochran из Texas Instruments создали первый микроконтроллер TMS1000. Этот чип объединил в одном корпусе 4-битный процессор (CPU), встроенную память (ПЗУ) с программой, оперативную память (ОЗУ) для данных и тактовый генератор – полноценную встраиваемую систему на кристалле. Вскоре микроконтроллеры начали быстро распространяться: японские производители электроники в 1970-х внедряли микроконтроллеры в автомагнитолы, электронные замки, а также в системы управления двигателем автомобилей.

Как программировались первые микроконтроллеры

Программирование ранних микроконтроллеров было настоящим искусством. Изначально инженеры писали код в машинном языке, то есть вручную составляли последовательности двоичных кодов (0 и 1) для каждой инструкции, а затем записывали их в ПЗУ устройства.

Например, простейшая операция сложения могла выглядеть как набор битов 1000 0001. Подобные «магические числа» нужно было знать и рассчитывать самому. Это было весьма утомительно и чревато ошибками, поэтому вскоре появились инструментальные программы – ассемблер. Ассемблер позволял записывать программу в виде понятных мнемонических команд (например, ADD R1 вместо двоичного кода), а затем автоматически переводил их в машинный код для конкретного микроконтроллера. Такой подход заметно ускорил разработку и снизил вероятность ошибок.