Быстрее, мощнее, эффективнее

Как при росте возможностей ИИ снизить его ресурсопотребление

Технологии искусственного интеллекта потребляют много ресурсов: электричество, воду, требуют дорогого оборудования. «РБК Тренды» изучили, как компании оптимизируют свои модели и как они внедряют энергоэффективные технологии и альтернативные источники энергии.

Сколько ресурсов тратит ИИ

Современные системы искусственного интеллекта требуют колоссальных вычислительных мощностей. Обучение и работа нейросетей сопровождаются значительным потреблением электроэнергии, использованием больших объемов данных и эксплуатацией мощного аппаратного обеспечения. Чем сложнее модель, тем выше ее ресурсозатраты, что становится ключевым вызовом для развития ИИ.

Электричество и CO2

Одним из самых ярких примеров ресурсоемкости ИИ является нейросеть GPT-4, разработанная компанией OpenAI. По разным оценкам, обучение GPT-3 потребовало около 1287 МВт·ч электроэнергии, что эквивалентно годовому потреблению 120 американских домов. Также известно, что ChatGPT в настоящее время может потреблять около 39,98 млн кВт·ч в день — нейросетью пользуются 400 млн активных юзеров еженедельно.

Исследование Университета Массачусетса показало, что создание одной модели нейросети может привести к выбросу более 280 тыс. кг CO2 — эквиваленту пятилетнего цикла эксплуатации автомобиля с двигателем внутреннего сгорания. Такие показатели вызывают обеспокоенность у экологов и подталкивают компании к поиску энергоэффективных решений.

Оборудование

Кроме электроэнергии, ИИ требует эксплуатации дорогостоящего оборудования: графических процессоров (GPU), тензорных процессоров (TPU) и серверных ферм — по оценкам Schneider Electric, в 2023 году 80% нагрузки ИИ-моделей в дата-центрах пришлось на генерацию результата, а 20% — на обучение.

Современные серверы, работающие с ИИ, генерируют большое количество тепла, и их охлаждение становится еще одной статьей расходов. Например, крупнейшие дата-центры, которые принадлежат Google или Microsoft, используют системы жидкостного охлаждения, чтобы снизить температуру процессоров и увеличить их производительность. Однако даже такие меры не устраняют проблему быстрого износа оборудования: современные GPU, работающие на полную мощность, могут терять производительность через 3–5 лет эксплуатации.

Вода

Менее очевидный, но значимый фактор, — это потребление воды. В 2023 году выяснилось, что центры обработки данных OpenAI потребляют миллионы литров воды ежегодно для охлаждения своих серверов. Исследования показывают, что на одно крупное обращение к ChatGPT может расходоваться до 500 мл воды в зависимости от климатических условий и типа системы охлаждения.

В условиях глобального изменения климата и дефицита водных ресурсов такие показатели не могут не вызывать вопросов о разумном использовании воды в технологической отрасли.

С ростом популярности ИИ-сервисов, таких как генеративные модели, автономные системы и продвинутые аналитические алгоритмы, потребление ресурсов будет только увеличиваться. Компании уже начали разрабатывать энергоэффективные чипы, использовать возобновляемые источники энергии и внедрять квантовые вычисления, но эти меры пока не решают проблему в полной мере.

В ближайшем будущем перед ИИ-индустрией встанет ключевой вызов: как сбалансировать развитие технологий и сохранение окружающей среды. Очевидно, что без комплексного подхода, включающего в себя оптимизацию моделей, развитие «зеленых» дата-центров и внедрение более экономичных алгоритмов, проблема чрезмерного ресурсопотребления искусственным интеллектом останется актуальной.

Как уменьшить расход ресурсов

Один из наиболее эффективных способов снижения потребления ресурсов ИИ — это оптимизация алгоритмов и моделей. Современные нейросети часто бывают избыточно сложными, что приводит к ненужным вычислительным затратам. Компании и исследователи работают над методами уменьшения размеров моделей без потери качества.

Наиболее известный исследовательский центр, занимающийся этой проблемой, — Суперкомпьютерный центр MIT Lincoln Laboratory (LLSC). В нем ученые разрабатывает методы, которые помогут центрам обработки данных сократить потребление энергии. Что особенно важно, исследователи обнаружили, что эти методы оказывают минимальное влияние на производительность модели.

Оптимизация алгоритмов и моделей

При разработке нейросетей важно не только добиться высокой точности, но и оптимизировать вычисления, особенно если модель должна работать на ограниченных ресурсах. Для этого используются различные методы.

Квантование

Квантование помогает уменьшить энергозатраты в вычислениях, снижая точность чисел, используемых для расчетов. Например, вместо 32-битных чисел, которые могут представлять диапазон от −2 млрд до 2 млрд, можно использовать 8-битные числа с диапазоном от 0 до 255. Это снижает потребление энергии и ускоряет процесс, поскольку для обработки меньших по объему данных нужно меньше ресурсов. В задачах, таких как распознавание изображений или текста, точность 32 бит избыточна, и переход на 8 бит существенно ускоряет работу модели.

Бинаризация весов

Бинаризация весов (Binary Neural Networks) ограничивает параметры модели всего двумя возможными значениями: вместо множества значений (например, от −1 до 1) они ограничиваются всего двумя: 0 и 1.

Это снижает потребление ресурсов, ускоряет обучение модели и уменьшает объем памяти, необходимый для хранения данных.

Прунинг

Прунинг (Pruning) исключает ненужные нейроны и связи в нейросети, сохраняя ее точность. Во время обучения модели могут появляться нейроны, которые не влияют на результат, и их можно удалить без потери качества. Например, в модели для распознавания изображений можно удалить нейроны, отвечающие за неважные детали, такие как фон, и тем самым сэкономить вычислительные ресурсы. Динамический прунинг позволяет модели оптимизироваться в процессе работы, исключая несущественные связи в зависимости от сложности текущей задачи, что снижает энергопотребление.

Эффективные архитектуры и адаптивные алгоритмы

Mixture of Experts (MoE) — это архитектура, в которой активируются только нужные части модели. Например, для перевода текста на английский язык используется только та часть нейросети, которая работает с этим языком, а остальные остаются неактивными. Это позволяет экономить ресурсы. Аналогичные технологии, такие как Sparse Transformers и Switch Transformers, активируют только те параметры, которые необходимы в момент выполнения задачи, что повышает эффективность работы модели.

Адаптивные алгоритмы могут динамически изменять свою сложность в зависимости от задачи, например используя модели с ранним выходом (early exit). Они заканчивают вычисления, если уверенность в предсказании достаточно высокая: это нейросеть вычисляет на основе своих внутренних параметров, обученных на примерах.

Новый подход к оборудованию и энергии

Второй важный способ — применение специализированного оборудования. Традиционные серверные процессоры (CPU) неэффективны для обработки ИИ-задач, поэтому используются графические процессоры (GPU) и тензорные процессоры (TPU).

CPU, GPU и TPU имеют различную архитектуру, соответствующую их назначению. CPU как универсальный процессор имеет несколько ядер для выполнения различных задач, в то время как GPU обладает большим количеством ядер, оптимизированных для параллельных вычислений, что делает его идеальным для обработки графики и ИИ-вычислений. TPU, в свою очередь, специализирован на выполнении операций с матрицами и векторными вычислениями, что делает его значительно более эффективным для задач ИИ по сравнению с CPU и GPU, особенно в обработке больших объемов данных и тренировки нейросетей.

Google создала TPU для удовлетворения растущего спроса на эффективную вычислительную мощность в службах ИИ, таких как поиск, YouTube и большие языковые модели DeepMind. Trillium, новейший TPU, обеспечивает пиковую вычислительную производительность в 4,7 раза выше на чип по сравнению с его предшественником и на 67% более энергоэффективен, что делает его мощным и устойчивым решением для рабочих нагрузок ИИ.

Помимо аппаратных решений, важную роль играет использование альтернативных источников энергии. Как уже говорилось, дата-центры, которые обрабатывают и хранят огромные объемы информации для ИИ-моделей, потребляют колоссальное количество электроэнергии. Ведущие технологические компании — Google, Microsoft, IBM — все чаще обращаются к возобновляемым источникам энергии, таким как солнечные и ветряные электростанции, для питания своих серверных мощностей. Бигтехи даже создают стратегии по строительству ЦОДов, работающих на альтернативной энергии.

Особый интерес вызывает использование атомной энергии для поддержки инфраструктуры ИИ. Microsoft, Google и Amazon уже рассматривают возможности интеграции небольших модульных ядерных реакторов (SMR) для обеспечения стабильного и чистого энергоснабжения дата-центров. SMR способны выдавать до 300 МВт(э), что делает их удобным решением для таких объектов. Для сравнения: мощность традиционных крупных ядерных реакторов превышает 700 МВт(э), а микроядерные реакторы могут обеспечивать до 10 МВт(э), что позволяет использовать их в удаленных районах и компактных инфраструктурных проектах.

Ядерная энергия позволяет обеспечить высокую производительность при минимальном углеродном следе: по данным исследования, опубликованного в рамках Конференции ООН 2021 года, у атомных электростанций уровень выбросов CO2 даже ниже, чем у ветряных станций.

Какие способы появятся завтра

Будущее искусственного интеллекта тесно связано с поиском решений, позволяющих снизить его ресурсопотребление. В ближайшие годы можно ожидать появления новых технологий, которые сделают ИИ более энергоэффективным, экологичным и доступным.

Квантовые вычисления для ИИ

Квантовые компьютеры способны значительно ускорить обработку данных и выполнение сложных вычислений, что потенциально уменьшит энергозатраты при обучении и работе моделей. Технологии квантового машинного обучения находятся на ранней стадии, но уже сегодня компании вроде IBM, Google и D-Wave активно развивают этот сектор.

Например, в 2019 году Google объявила о достижении квантового превосходства, выполнив вычисления, которые традиционный суперкомпьютер не смог бы завершить за разумное время. Кроме того, IBM работает над квантовыми алгоритмами оптимизации, которые смогут применяться в задачах ИИ.

Помимо вычислительных преимуществ, квантовые технологии могут существенно повысить энергоэффективность. Некоторые исследования показывают, что в определенных случаях квантовые компьютеры могут быть в 100 раз более энергоэффективными, чем классические суперкомпьютеры.

Анализ энергопотребления 500 крупнейших суперкомпьютеров мира за последние 20 лет также подтверждает этот потенциал: квантовый компьютер с аналогичной вычислительной мощностью потреблял бы менее 0,05% электроэнергии по сравнению с самым энергоемким суперкомпьютером из списка.

Самообучающиеся и адаптивные модели

Будущие модели ИИ будут способны автоматически адаптироваться к поставленным задачам, минимизируя необходимость в полномасштабном обучении. Это позволит сократить потребление вычислительных ресурсов. Примеры подобных технологий включают sparsity-aware-алгоритмы, которые активируют только нужные части модели, и Zero-Shot Learning, позволяющий моделям обучаться без предварительной подготовки на больших наборах данных.

Например, компания OpenAI разрабатывает модели, такие как CLIP и DALL-E, способные выполнять сложные задачи без традиционного обучения на специализированных данных. Также исследователи из Массачусетского технологического института (MIT) работают над технологиями, позволяющими моделям динамически адаптироваться к нагрузке, снижая потребление электроэнергии.

Децентрализованные вычисления и Edge AI

Edge-компьютинг — это подход, при котором обработка данных происходит не в удаленных дата-центрах, а непосредственно на локальных устройствах. Это позволяет снизить энергопотребление и уменьшить задержки в работе ИИ.

В сочетании с технологией блокчейна децентрализованные вычисления позволят создать сети, где устройства обмениваются ресурсами и данными, минимизируя нагрузку на глобальные серверные мощности.

Например, компания Nvidia активно развивает Edge-AI-устройства, такие как Jetson Nano, которые позволяют выполнять сложные вычисления на устройствах интернета вещей с минимальным энергопотреблением.

Но несмотря на широкий интерес к этой технологии, точные данные о реальном снижении энергопотребления в массовом использовании остаются ограниченными. Большинство заявлений о преимуществах Edge-компьютинга основаны на теоретических моделях или отдельных тестах, результаты которых редко публикуются в открытом доступе.

«Оценка воздействия технологий ИИ игнорирует эффект замещения»

Свою точку зрения на проблему ресурсоемкости технологий высказала в колонке на сайте «РБК Тренды» Юлия Мицкевич, директор ИИ-направления компании KODE. В частности, вот на что она обращает внимание:

«Цифровые технологии заменяют физические объекты на цифровые данные и способствуют декарбонизации экономики. Например, отправка электронного сообщения заменяет отправку письма по почте, просмотр фильма заменяет прокат DVD-диска, а участие в видеоконференции — личную встречу.

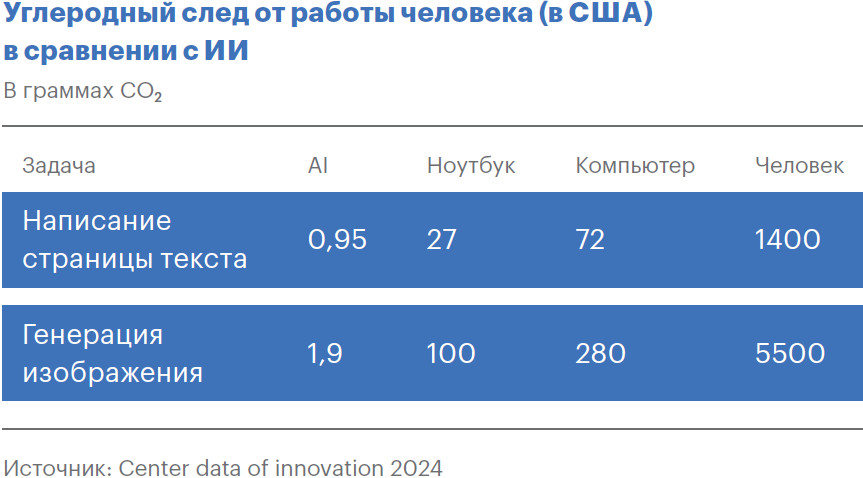

В исследовании, проведенном в 2023 году, было проанализировано воздействие на окружающую среду человека и искусственного интеллекта при написании текста или создании иллюстрации. Результаты показали, что при написании текста углеродный след от ИИ в 1,5 тыс. раз меньше, чем у человека, а при создании изображения — в 2,9 тыс. снижает выбросы от его ноутбука или настольного компьютера.

Как показано в таблице, экономическая выгода может быть значительной, но делать выводы еще рано. Возможно, упрощение создания текста и изображений приведет к увеличению объема работ.

В свете огромного потенциала использования искусственного интеллекта в экономике и обществе, включая переход к низкоуглеродному будущему, крайне важно, чтобы исследования о влиянии ИИ на окружающую среду были основаны на достоверных данных»